関連するソリューション

セキュリティサービス

セキュリティ製品

業務改革

AI

IDアメリカ

ハムザ・アフメッド

AIが大流行している昨今、製品にAIを導入する計画を、株主に向けて発表する企業が増えています。

ChatGPTの一般化は、AIをビジネスにどのように活用できるかを各企業に考えさせるきっかけとなりました。もしAIを導入しなければ、競合他社が導入し、自社のビジネスに打撃を与えかねないというのが業界の合意です。Microsoft社がBingにOpenAIの実装を急いだり、GoogleがBardの一般公開を急いだりするのもそのためです。

サイバーセキュリティではAIが必要不可欠な技術です。90年代後半から、アメリカ国防高等研究計画局(DARPA)は、異常検知システムに機械学習の導入を試みましたが失敗に終わりました。

しかし、2000年代半ば以降、AIはサイバーセキュリティ製品に定期的に追加されるようになっただけでなく、ネットワーク環境がより多様で高密度になるにつれて必要不可欠なものとなりました。

AIの最初の成功例は、アルゴリズムを訓練するために教師あり学習を使用したスパム、URL、フィッシング・フィルタリングでした。それ以来、AIはネットワーク・トラフィックの検出、振る舞い検出(UEBA)、システム評価に使用されています。

これまでは、AIは主に検知のためにバックエンドに配置されていましたが、生成AIの登場により、それも変化するでしょう。生成AIは攻撃者のアプローチだけでなく、サイバーセキュリティの専門家のアプローチも変えていきます。

この記事では、脅威行為者が生成AIをどのように攻撃に利用するか。そしてサイバーセキュリティの専門家が進化する脅威にどのように対応できるかを探ります。

脅威行為者による生成AIの利用

生成AIを使ったことがある人であれば、それが潜在的な脅威となりうることを理解できると思います。すでに、生成AIが脅威行為者によって悪用されている事例は複数あります。これまでの最大の脅威のひとつは、政府機関から個人情報まで機密情報の流出でした。しかし、今後我々が目にすることになるであろう攻撃は、何らかのウイルスに感染しているデータに基づいて、ユーザーの行動を操作するものになっていくでしょう。

以下は、脅威行為者による生成AIの使用例です。

フィッシング攻撃

これまでのフィッシングメールは、誤字脱字、文法的誤り、一貫性のないトーンによって識別することができました。しかし、生成AIによって作成されたフィッシングメールは、正規のソースとほとんど見分けがつかず、AIを使わなければ識別できないところまで向上しています。Facebook BusinessでAIフィッシング・メールが使用され、機密情報を盗み出そうとした事例はすでにいくつかあります。

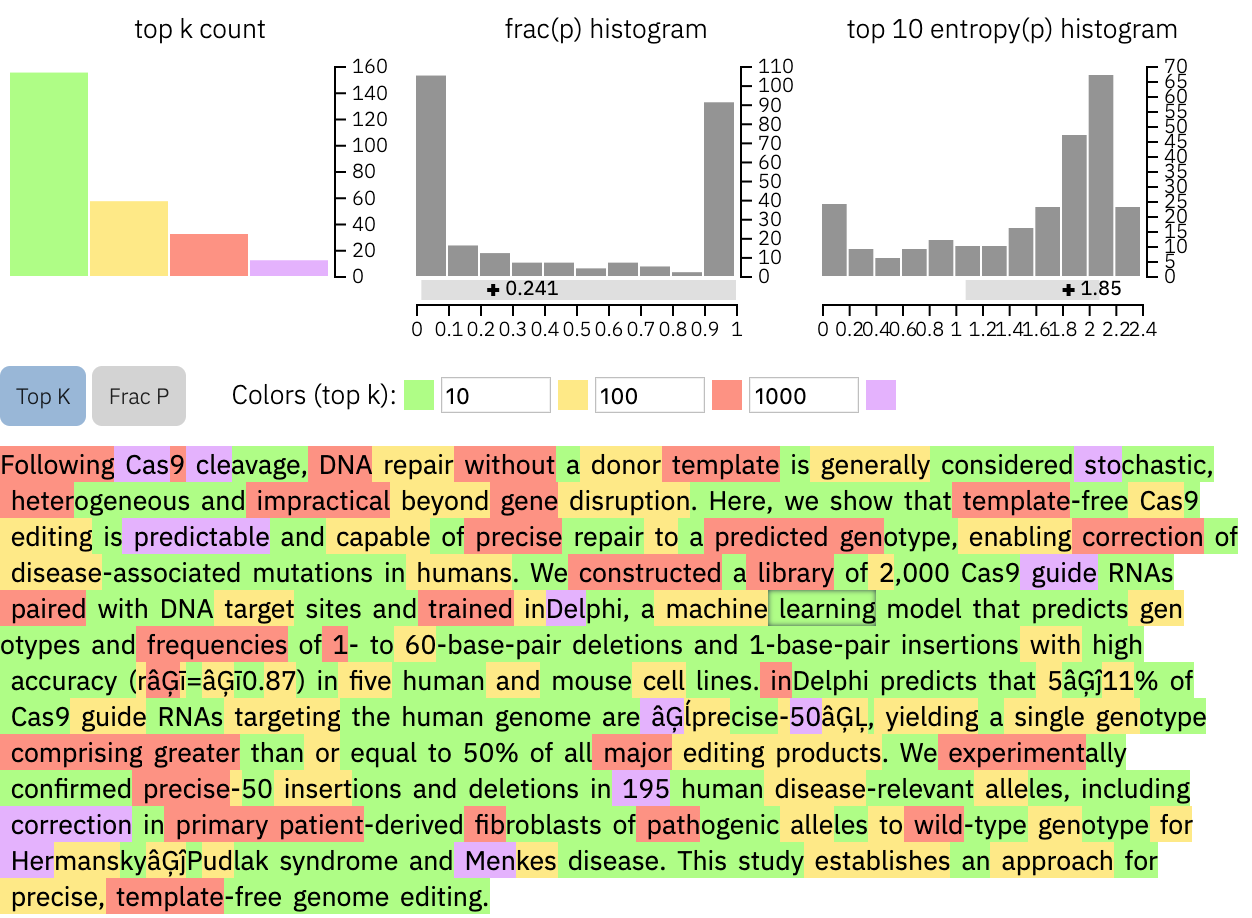

出典:http://gltr.io/

AIによって生成されたコンテンツであることを識別するために使用されたツールは、OpenAIによって提供されていましたが、その精度の低さからOpenAIによって閉鎖されていました。

今となってはGPTZeroのようなサードパーティーのサービスに頼るしかありませんが、テストした結果、正解率は低かったです。つまり、テキストがAIによって生成されたかどうかを識別する手段がないのです。

今後、信頼できる識別ツールができたとしても、より多くの企業がAIを活用してより多くのタスクを自動化するようになれば、正当なAI自動化メールと脅威行為者を区別する方法がなくなるかもしれません。

その正当性を識別するためには、メールやメッセージの内容以外のデータに頼る必要があるでしょう。

偽アイデンティティ

2017年以降、ディープフェイクと呼ばれる新技術が一般に紹介されるようになりました。ディープフェイク技術は、動画に映る人物の顔を別の人物の顔にシームレスに重ね合わせることを可能にするもので、以前は映画製作者が手作業で実現していましたが、現在では高度なディープフェイク・ソフトウェアによって自動化され始めています。

さらに、生成AIの台頭により、Midjourneyのようなツールで生成された画像を使って偽のIDを作成し、完全に架空の人物を作り上げる詐欺行為が増加しています。

DALL·Eで生成した顔写真(このような存在しない人がネット上で増加)

詐欺師は、生成された人物の顔の画像と、資格や経験、ソーシャルメディアにおけるデジタル・プレゼンスに関する捏造された情報を組み合わせることで、この技術を悪用します。

この悪意のある調合により、完全に架空のペルソナを作成し、リモートワーカーを抱える企業に潜入し、貴重な情報を盗むなどの悪事を実行することができます。

このような攻撃に対抗するための課題のひとつは、こうしたアイデンティティのバーチャルな性質です。これらの作り物の顔や声を持つ人が存在しないため、詐欺の背後にいる犯人を追跡し、特定することは極めて困難です。

政府機関や企業にとって、労働者を組織に受け入れる前に、より強固な方法で身元を確認することがより重要になるでしょう。これは、AIが生成した顔を識別できるソフトウェアの導入や、オンプレミス認証と改善されたバックグラウンド・チェックの組み合わせによって行う必要が増えると思われます。

偽情報

3月、ロシアの指導者ウラジーミル・プーチンが習近平にひざまずき、現在進行中のウクライナ戦争への支援を中国政府に懇願しているらしい画像がツイッターに投稿されました。

この投稿画像は奇妙に見え、すぐにAIから生成されたものだと特定されましたが、この画像はその時点で1000万人以上のユーザーに見られてしまっていました。

出典:https://twitter.com/GlasnostGone/status/1637856891882835968?lang=en

ネット上には常に偽情報が投稿されていますが、多くは簡単に特定できました。しかし、今やMidjourneyやStable Diffusionのようなツールを使えば、フェイク画像を生成するのは簡単です。

まだフェイク画像を特定できる段階とはいえ、このような誤った情報に騙される人がいることは避けられず、情報はインターネットを駆け巡るため、誰かがフェイクだと特定するまでに被害が拡大する可能性があります。

生成AIを使えば、偽情報を高いスケーラビリティで展開することができます。インターネットは偽の画像や情報で溢れかえり、正当な情報をかき消すことができてしまうのです。これは、インターネットの終焉につながる可能性があります。

今後、私たちは情報の検証を見直す必要があります。その情報が信頼できる情報源から発信されたものなのか、そうでないのかを判断できることが重要となります。この点で、ブロックチェーン技術は身元確認を行う際に有効です。

サイバーセキュリティのための生成AI

AIが悪用される可能性が大きいことを認める一方で、生成AIはサイバーセキュリティの専門家の手にかかれば、非常に効果的なツールとしても機能することを認識することが重要です。

AIに関連するリスクを過小評価してはならないですが、責任ある倫理的な生成AIの使用は、サイバーセキュリティの取り組みを大幅に強化し、デジタル防御を強化することができます。

高品質の合成データ

サイバーセキュリティ企業が直面する最も重要な課題の1つは、AIシステムをトレーニングするための適切かつ包括的なデータを入手することです。多くの企業は、機密情報を含むネットワーク・トラフィック・データの共有をためらっており、多様で貴重なデータセットの利用が制限されてきます。

クラウドセキュリティの採用によって、この懸念はある程度緩和されたものの、データへのアクセスはサイバーセキュリティ業界にとって継続的な問題です。ありがたいことに、生成AIは学習目的の合成データの作成を可能にすることで実世界の情報への依存を減らし、有望な解決策を提供してくれます。

洗練されたアルゴリズムを利用することで、生成AIは機密データを損なうことなく、膨大な量の現実的なネットワーク・トラフィックや攻撃シナリオをシミュレートすることができます。これによりサイバーセキュリティ企業は、従来のデータセットに依存しない強力なAIモデルを構築することができ、データ取得やデータ共有の課題を軽減することができます。

さらに、合成データの使用は、AIアルゴリズムのバイアスを最小限に抑える強力なツールとなり得ます。慎重に作成・管理された合成データを生成することで、サイバーセキュリティの専門家は、よりバランスの取れた偏りのないトレーニング環境を確保し、AIシステムの精度と公平性を高めることができます。

合成データを作成するために生成AIを採用するもう1つの利点は、斬新なシナリオを導入し、進化するサイバー脅威に継続的に適応できることです。サイバーセキュリティの状況が急速に進化する中、AIシステムは多様で動的なデータセットで訓練されることが極めて重要です。

しかし、生成AIは計り知れない可能性を提供する一方で、合成データに関連する潜在的なリスクについても認識する必要があります。合成データが実世界の状況を正確に表していることを確認するには、入念な検証とテストが必須です。サイバーセキュリティ企業は、AIシステムの訓練に使用する合成データの真正性と有効性を検証するために、強固な品質保証手段を導入しなければなりません。

DALL·Eで生成されたイメージ

拡張ハッカー・シミュレーション

個人の行動を模倣する能力は、サイバーセキュリティの分野で二重の利点を提供します。脅威行為者がこの能力を悪用する可能性があるのは事実ですが、サイバーセキュリティ・チームに大きな利益をもたらす建設的な応用もあります。そのような応用例の1つが、生成AIを使用してレッド・ハッカーや敵対者をシミュレートすることです。

レッド・チーミングとは、サイバーセキュリティの専門家が攻撃者として組織の防御をテストすることです。生成AIを活用して模擬レッドハッカーを作成することで、セキュリティチームは包括的かつ制御された侵入テストを実施することができます。

これらのAI駆動型レッド・ハッカーは、さまざまな攻撃戦略や技術を模倣することができるため、組織は現在のセキュリティ実装の有効性を評価することができます。

従業員に最新の攻撃の巧妙さを理解させ、電子メールやテキスト・メッセージに応答する前に確認するための特別な対策を講じることができるようにするために、生成AIを使用して定期的なセキュリティ・トレーニングを実施することができます。

コンテクスチュアルなサイバーセキュリティ

ネットワーク・セキュリティの大部分は、ログを調べて問題がないかどうかをチェックすることです。ネットワークで発生するトラフィックの量に伴い、セキュリティの専門家が最も関連性の高いネットワーク・アクティビティだけを簡単に選別できるよう、アラート・システムやログ・フィルタリングが導入されてきました。しかし、提示されたデータを文脈的に理解できるようになるまでには、時間が掛かります。

もう1つの問題は、大規模な組織では、異なる部門の行動を理解することが難しく、誰も気づかないうちに不審な行動が実行されている可能性があるということです。行動の誤動作を検知するUEBAはあるが、セキュリティ・チームがログだけで状況の全体像を把握するのは難しいことです。

生成AIを使えば、組織に関するデータで、オペレータのためにネットワーク・トラフィックを文脈化し、状況の全体像を把握することができます。これにより、オペレータは該当部署を調査する必要性が減り、負担が軽減されます。また、新しいセキュリティ・プロフェッショナルが会社の業務全体を理解する必要がなくなります。

今後の懸念と期待

AIがもたらす潜在的な脅威について、著名な技術リーダーや専門家の声が高まっています。この脅威は、脅威行為者によるAIの使用だけでなく、悲惨な結果につながるAIの一般的な使用にも及ぶと思われます。

「AIによる絶滅のリスクを軽減することは、パンデミックや核戦争といった他の社会規模のリスクと並んで、世界的な優先事項であるべきだ。」~ Center for AI Safety

この声明は「Center for AI Safety」によって5月に起草され、OpenAIのCEOであるサム・アルトマン、Microsoft元CEOビル・ゲイツ、グーグルのAI研究者、世界の様々なトップ機関の複数の教授を含む350人以上の幹部が署名しました。また、3月にもイーロン・マスク、スティーブ・ウォズニアック、その他数百人の著名人が署名したAIの危険性を警告する声明が発表されています。

これらすべての最大の懸念は、企業が主導するAI競争と、一般への急速な展開の背後にある議論の欠如です。この2つの声明では、この技術を安全に活用するための適切な対策を構築するために、最低でも6カ月間はAI研究を停止するよう、すべての研究者の間で休戦を勧告しています。

規制とコンプライアンス

世界中で政府による議論が続いており、指導者たちはAIに規制を設けようとしています。企業内のAIを規制するのに役立つフレームワークやデータを提供しようとしている組織はすでにいくつかあります。

- NIST

国立標準技術研究所(NIST)は今年初め、「信頼できる責任あるAIリソースセンター(Trustworthy and Responsible AI Resource Center)」を立ち上げました。

このセンターの主な目的は、AIに関する現行の連邦政府ガイダンスの多くを保管することであり、公的機関や民間団体が同様に責任あるAIシステムを構築するのに役立つ、過去に発行された資料へのアクセスを可能にします。

また、NISTのAIリソース管理フレームワークとAIプレイブックを公開し、包括的な連邦法がない社会的に責任のあるAIや機械学習システムの研究開発における業界のベストプラクティスを支援しています。NISTのウェブサイトに記載されているように、このフレームワークはAIの進化に伴って変更される可能性があり、今年後半には最新版がリリースされる見込みです。

- OECD AI

経済協力開発機構(OECD)は、世界各国の政府がエビデンスに裏打ちされた政策を確立できるよう支援する国際機関です。また、透明性を促進するため、誰でも利用できるデータを提供しています。2019年、AIの影響と安全な使用のための推奨政策を調査するAI部門を設立しました。

目標はAIの世界的な政策を策定することです。OECD AIは、AIの使用に関する多くのデータを提供するだけでなく、AIのガバナンスやリスク管理のための支援やツールを提供する企業も紹介もしています。

- Safe.ai

Safe.aiは、AIの安全性に関する研究を行い、政策立案者に提言を行っています。非営利団体で、AIに関する懸念を記した手紙を送り、350人以上の署名を集めた組織です。

- AI impact

AI Impactは、社会におけるAIの影響に関する調査を掲載し、研究者や業界関係者を対象に定期的に世論調査を行い、AIの現状を把握しようとしています。最新の世論調査では、研究者(487人)の50%が、AIが世界を終わらせる可能性は10%だと考えていることを発表しました。

最後に

サイバーセキュリティの将来は、主にAI技術の急速な進歩により非常に不透明なままです。AIが加速度的に進歩し続ける中、デジタル・システムを守るために私たちが行っているサイバーセキュリティ対策は、予想よりも早く時代遅れになるかもしれません。

しかし、サイバーセキュリティへの投資が無意味になるわけではなく、むしろ組織が柔軟性を受け入れ、業界の新たな発展に対する感度を高める必要性を浮き彫りにしてきています。

サイバーセキュリティの不確実な未来において一歩先を行くには、ダイナミックで包括的なアプローチが必要です。AI主導のテクノロジーを採用し、適応力を養い、脅威インテリジェンスを共有し、従業員教育に投資することは、明日の課題に耐えうるレジリエントなサイバーセキュリティフレームワークを構築する上で極めて重要な柱となります。

最後までお読みいただきありがとうございました。

それではまた、次のコラムでお会いしましょう。

当サイトの内容、テキスト、画像等の転載・転記・使用する場合は問い合わせよりご連絡下さい。

エバンジェリストによるコラムやIDグループからのお知らせなどを

メルマガでお届けしています。