関連するソリューション

業務改革

AI

エバンジェリスト・フェロー

玉越 元啓

はじめに

ここ数年AIがかなり身近に感じるようになりました。特に生成系AIの発展が目覚ましく、画像や文章の生成など様々な場面で利用されているのを目にします。広く受け入れられるようになったせいか、AIに対する否定的な意見も目にする機会が増えてきました。新しい技術に対して、賛否両論出ている現状は、新しいモノが受入れられ社会に浸透していく通過儀礼であり、非常に望ましい状況だと捉えています。

温故知新、AIに関するいくつかの事件を振り返り、AIに関する倫理や規制の現状について考察していきます。

AIの倫理に関する事件

アマゾンのAI採用

アマゾンは2014年に、応募者を自動的に評価し、採用候補者を選出するAIツールの開発に着手しました。開発されたAIは、過去10年分の履歴書を分析し、評価されるべき応募者の人材像を学習しました。2015年に、AIが「女性差別」をする傾向があることが判明しました。AIは「女性」という単語を含む履歴書の評価を下げ、女子大の出身者には低い点数しか与えないというルールを自ら編み出していたのです。

この事例は、AI技術の公平性と倫理的な使用について議論を呼び起こす重要な例となりました。アマゾンはその後、AI採用のプロセスを見直し、公正な選考を目指す方針に切り替えています。

参考:

焦点:アマゾンがAI採用打ち切り、「女性差別」の欠陥露呈で

Amazon AI | Amazon.jobs

内定者が入社する確率の提供

リクルートキャリア(以下、リクルート)が提供していたAIサービス「内定者が入社する確率の提供」は、就活生の内定辞退率を予測するために開発されました。しかし、このサービスは倫理的な問題を引き起こし、停止される結果となりました。リクルートは過去の内定辞退者のデータを企業に委託契約という形で共有しており、その辞退者のリクナビ上での過去の行動履歴データをAI解析し、内定辞退をした者の行動パターンや属性を抽出していました。

今年の選考者リストを企業側から受け取り、過去の内定辞退者に似た行動を取っている人物を選定し、企業側に選考者の「内定辞退率」を予測値として提供していました。

問題点は2つあり、一つ目は、過去の内定辞退者に基づき辞退者とそうでない人の「特徴量の抽出」をすることは難しい(言い換えれば精度の高いAIにはなりにくい)こと、もう一つは、こちらの方が重大で、8000人以上の学生から同意を得ないでデータを委託元の企業に提供していた個人情報保護法違反にあります。

2件の違いと得られる気付き

アマゾンの件は、AIに学習させるためのデータに偏見が含まれていたため過ちが起きることとなりました。このことに人が気づくことができ運用を停止することができた点において、ガバナンスが有効に働いていた例としてとらえています。リクルートの件は、個人情報保護法違反というAI以前の問題で、法律に反しているにもかかわらずプロジェクトが遂行されてしまったというガバナンスが機能しなかった(少なくとも当時は)例としてとらえています。

両件に共通していえるのは、AI が勝手に間違えたのではなく、AI が学ぶためのデータを集めて検証したり、そもそも順法意識が希薄なままプロジェクトを推進したり、という謂わば人が間違っていたのです。

こうした事例が起きないよう未然に防止する仕組みとして、現在、様々な規制や制度化が進められています。現在、開発中のAIはもとより、運用中のモノも含めて、動向を押さえて対応していく必要があります。

EUのAI規制

背景と目的

世界初の包括的なAI規制として、欧州連合(EU)はAIの開発と利用に対する法的枠組みを整備しました。その目的は、AIの透明性、安全性、および基本的権利の保護を強化することにあります。EUのAI規制法案「AIAct」の正式な文書がEUR-LEXで公開されています。参考:AIActの正式文書 (EUR-LEX)

規制の要点

規制の要点は、リスク分類/透明性/制裁金の3点になります。まず、AIのリスクを4つのレベルに分類し、それぞれのリスクに応じた要件を設定しています。無害なAI

(例:スパムフィルター)から、高リスクAI(例:自動運転車の制御)まで、幅広いAIをカバーしています。

AI の透明性を確保するための要件として、システムの提供企業に対して、AI製であることを明示させることを求めています。最後に、違反企業には制裁金を科すことで、規制の遵守を促しています。

影響と課題

2024年春に公布・施行される見通しで、最速で2026年中に適用が開始される予想です。AIを含むサービスをEU内に提供する企業やEU内で利用する企業にとって、欧州および国際の標準化が対応の鍵となります。

また、元々国内のAI のエンジニアはAIの倫理的な使用に対する意識が高いものでしたが、EUの規制は国際的な

AI開発者や企業にも影響を与えることとなっています。

私自身も、透明性要件があることによって、技術革新を目指すだけではなく、利用者からの信頼とバランスを取る必要性を感じています。

日本のAI規制と法整備の状況

内閣府・AI戦略会議

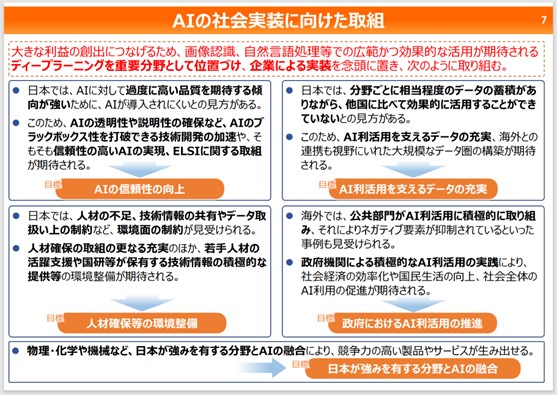

内閣府が発表した「AI戦略2022」では、AIの利活用に向けた具体的な目標が示されています。

引用元:AI戦略2022の概要 – 内閣府

これは、「人間尊重」、「多様性」、「持続可能」の3つの理念のもと、Society 5.0の実現を通じて世界規模の課題の解決に貢献し、社会課題の克服や産業競争力の向上を目指すものです。

社会実装の充実に向けて新たな目標の例として、高精度リモートセンシングデータの収集・分析・配信技術の開発や、気象・地震動・洪水・土砂災害の予測システムの構築、船舶交通の安全確保と海上輸送の効率化を目指したシステムの構築、説明可能なAIシステムの研究開発などが挙げられます。

様々な課題はAI だけで克服できるものではありませんが、私もAI が解決の糸口となり、また閉塞感を打破する起爆材となれるよう日々取り組んでいます。

経済産業省

経済産業省が設置した「デジタル空間における情報流通の健全性確保の在り方に関する検討会」では、AI技術の利用による情報流通の健全性を検討しています。インターネット上の偽・誤情報対策に関する意見募集では、AI技術を活用した偽情報の検出や対処策について議論が行われています。

参考:総務省報道資料 インターネット上の偽・誤情報対策に関する取組についての意見募集

知的財産戦略推進事務局

内閣府の知的財産戦略推進事務局では、「知的財産推進計画2023」において、AI技術と知的財産の関連に焦点を当てて検討しています。参考:知的財産推進計画2023 (概要)

生成系AIやAIが組み込まれたツールの急速な普及により、人間による創作と区別がつかないAI生成物が大量に生成され、クリエイターの創作活動に影響を及ぼすことが懸念されています。このAI生成物が著作権法上の著作物として認められるかどうかは、様々な観点から検討されています。

以下は、AI生成物の著作権性に関連する具体的な事例と検討されているポイントです:

- AI生成物の著作権性:AIが自動的に生成した作品(例:詩、音楽、絵画、小説など)は、著作権法上の著作物とみなされるかどうかが問題となっています。

一部のAI生成物は、クリエイティブで独自性があり、人間の創作物と同様に著作権の対象となる可能性があります。

- 著作権侵害の成否:AI生成物が既存の著作物と酷似している場合、著作権侵害の問題が生じます。一方、AIが完全に独自の作品を生成した場合、著作権侵害のリスクは低くなります。

- 人間の創作性とAIの役割:著作権法は、人間の創作性を保護するために設計されています。

AIが創作活動に関与した場合、その役割や創造性の度合いに応じて著作権性が判断されます。

IEEEのAI倫理ガイドライン

IEEEのガイドラインは国際的な共通基準として広く受け入れられており、AIの開発者や利用者に向けた指針となっています。IEEEはAI倫理に関するガイドラインを策定しています。これには透明性、公正性、プライバシー、安全性などが含まれています。

特に、IEEE 7000-2021は、倫理的懸念をシステム設計の過程で考慮するためのモデルプロセスを提供する規格で、組織が概念探索と開発の段階で倫理的価値を考慮するための一連のプロセスを確立できます。

この規格では、運用コンセプト、倫理的要件、倫理的リスクベースの設計における倫理的価値の追跡を提供するプロセスが記述されています。自社のライフサイクルモデルを使用するあらゆる規模とタイプの組織が、この規格に関連しています。

参考:IEEE SA - IEEE 7000-2021 - IEEE Standards Association

人工知能学会内でもIEEEの策定にかかわっているチームがあり、昨年の学会では、用語の定義や日本語化/英語化に苦慮していると話をしていました。今年の6月に詳しく聞ける機会があるので、進展については別途レポートします。

まとめ

EUのAI規制は2026年中の適応を予想しています。これまでに規制内容の把握と準備を済ませておきましょう。

生成系AIを利用する際によくでる課題には、以下のようなものがあります。

情報漏洩のリスク:AIが学習した内容が外部に流出するリスクは、セキュリティ対策を強化することで軽減できます。例えば、データ暗号化、アクセス制御、ユーザー認証などを実施することで情報漏洩を防止できます。

社内規定やマニュアルに基づく回答:独自の文書やマニュアルをもとに回答するために、AIのカスタマイズが必要です。特定のドメイン知識を持つAIモデルをトレーニングし、企業内の情報に適切にアクセスできるようにすることで、社内規定に準拠した回答が可能となります。

こうした課題に対応した製品がでてきており、利用することでAIを安全かつ効果的に導入し、ガバナンスを確立できます。検討してみてはいかがでしょうか。

参考:ID AIコンシェルジュ

新たな技術やサービスの出現によりデジタル空間が拡大・深化している中で、実空間に影響を及ぼす新たな課題が発生しています。これからも規制・法整備の動向について情報を発信していきます。

当サイトの内容、テキスト、画像等の転載・転記・使用する場合は問い合わせよりご連絡下さい。

エンジニアによるコラムやIDグループからのお知らせなどを

メルマガでお届けしています。